Ich habe ja bereits eine Übersicht zu KI auf dem eigenen PC geschrieben. Doch hier geht es konkret um das Programm ollama, mit dem man eine grosse Auswahl an frei verfügbaren Modellen wie Deepseek R1, Alibaba QWEN3, Google Gemma3 oder Meta LLama ganz einfach herunterladen und nutzen kann. Unten habe ich noch kurz beschrieben, wie man gar einen eigenen KI-Server einrichten kann.

Wieso sollte man das aber tun? Nun, Neugierde ist sicher ein guter Grund, Privatsphäre ein weiterer. Ein lokales LLM funktioniert unabhängig der Cloud der Grosskonzerne (selbst wenn einige wie Google und Meta solche Modelle anbieten). Alle Berechnungen laufen auf dem eigenen Computer, es geht nichts ins Internet. Wer auf Privatsphäre achtet, findet hier einen Weg, problemlos mit einer KI zu chatten. Zudem sind alle hier erwähnten Programme und Modelle kostenlos – auch das ein Unterschied zu den Abos vieler Anbieter.

Je nach Computerausrüstung sind nicht alle Modelle verwendbar. Sie sollten gut in den Arbeitsspeicher passen, wenn es gar für den VRAM der nVidia-Grafikkarte reicht, kann man mit raschen Antworten rechnen. Ob die Antwortgeschwindigkeit für den persönlichen Geschmack ausreichend ist, probiert man aber am besten selbst aus.

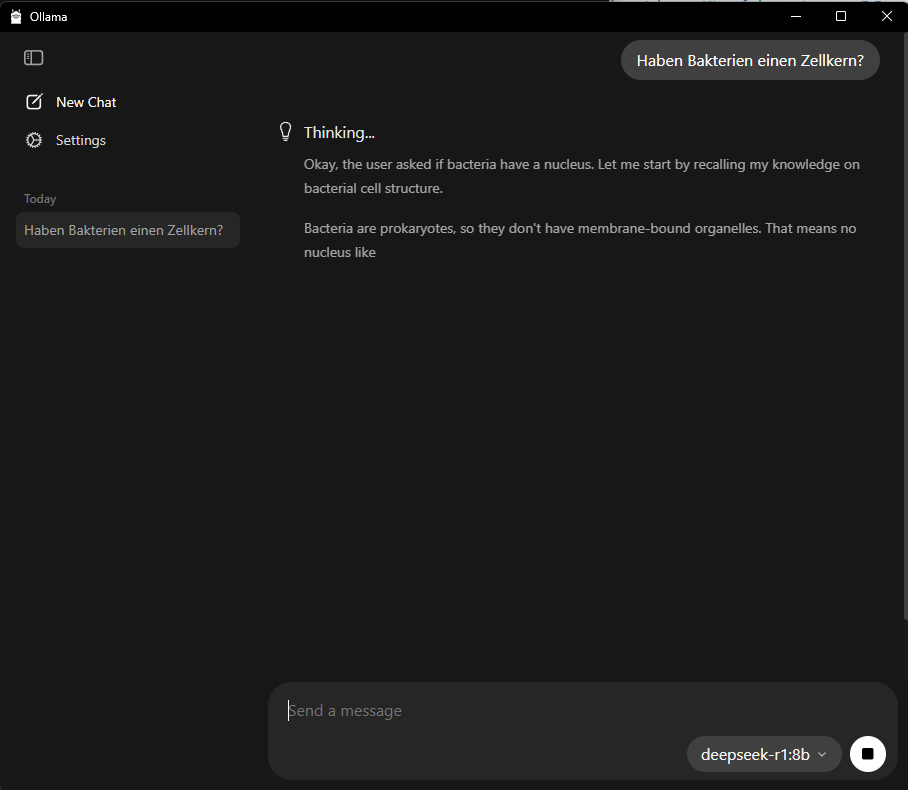

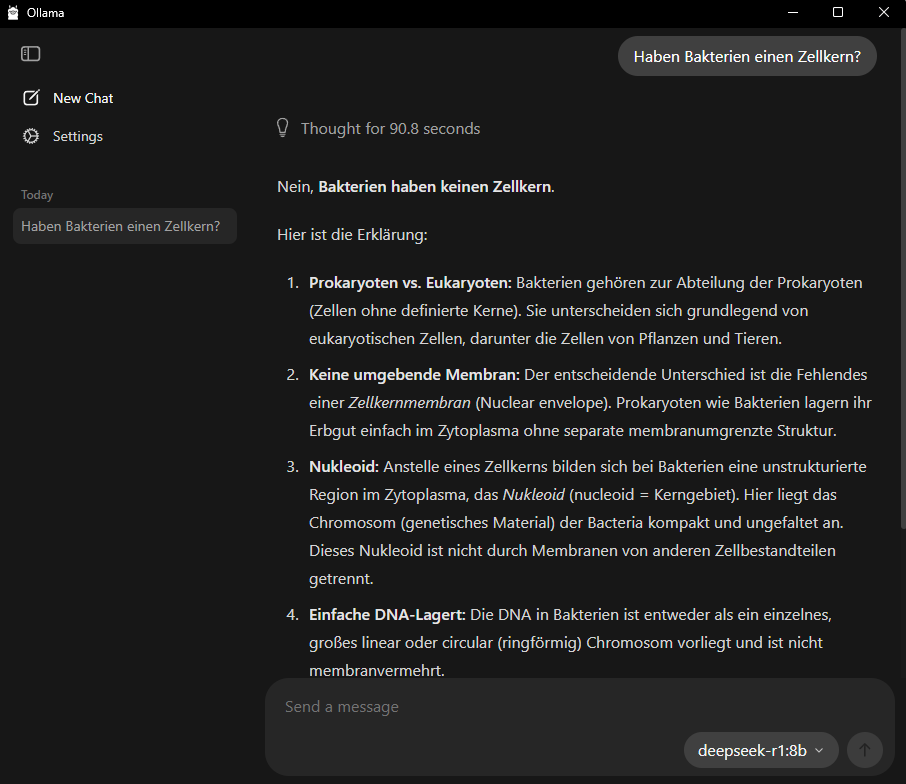

Ollama läuft in der Konsole, aber es gibt auch eine grafische Oberfläche. Diese ist intuitiv und ähnelt sehr derjenigen anderer Chat-KIs wie chatGPT oder Claude.

Bei einigen Modellen wie Deepseek R1 kann man beim “Denken” zusehen. Das ist ganz unterhaltsam, kann aber dauern. Falls kein Nachdenken nötig ist, sind andere Modelle schneller. Die kleinen Modelle kommen nicht ganz an die Qualität der grossen Modelle heran, sie sind aber nahe dran. Hier wurde das kleine Modell von Deepseek R1 verwendet (das 8 GByte Modell, im Vergleich zum online 671 GByte Modell)

Der eigene LLM-Server

Es ist sogar möglich, auf diese ollama-KIs im eigenen Netzwerk oder gar von irgendwoher zuzugreifen, beispielsweise mit dem Smartphone von unterwegs aus mit der KI auf dem Laptop zu Hause chatten.

Wir brauchen dazu ein installiertes ollama sowie die Weboberfläche WebUI. Diese installiert man am besten als Docker-Container. Nun kann man ollama bereits im gesamten eigenen Netzwerk nutzen (z.B. im WLAN zu Hause).

Falls man Zugriff aus dem Internet möchte, braucht es noch einen Tunnel, den man einfach via TryCloudFlare starten kann.